Emploi du temps – Semaine en cours

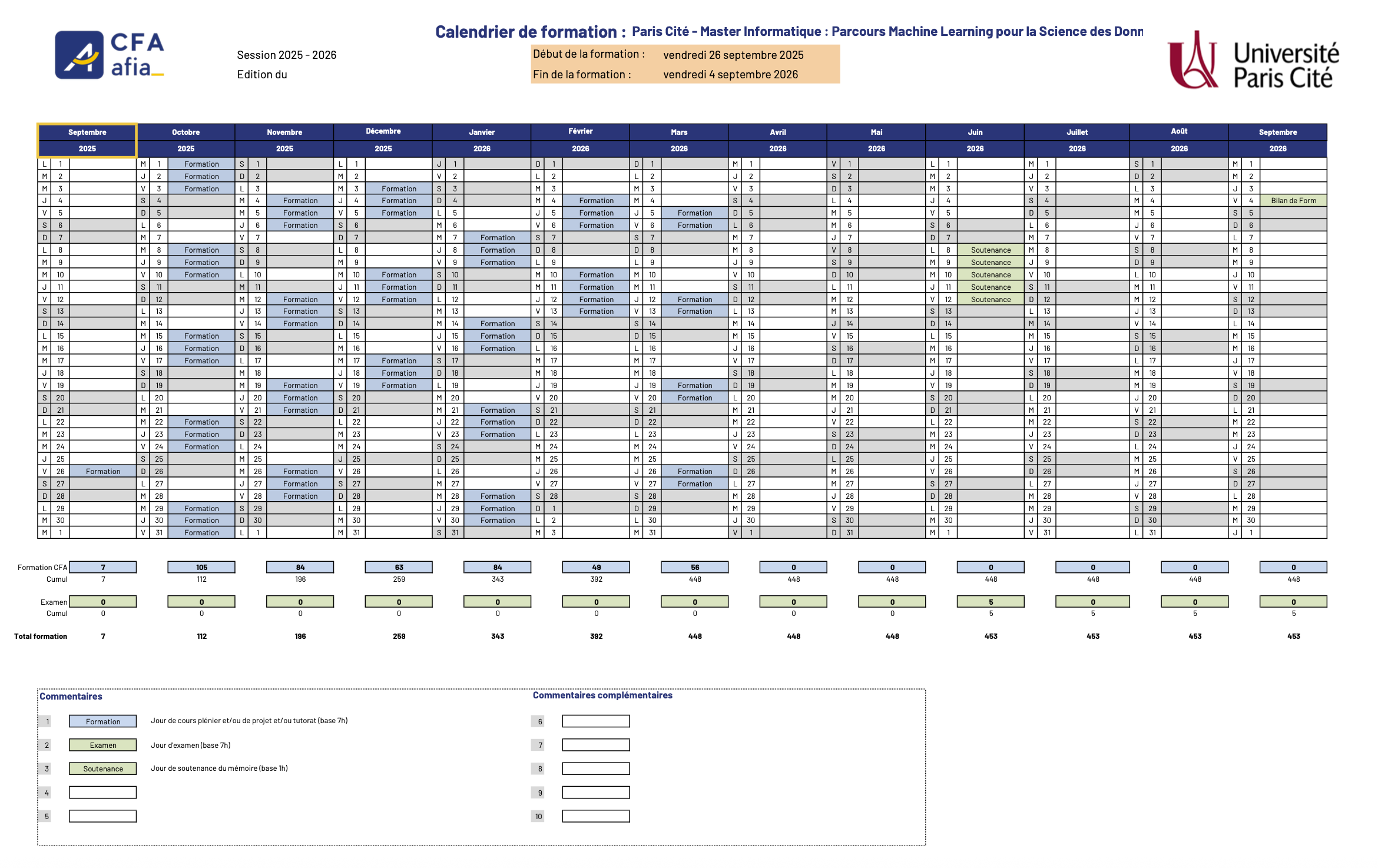

Calendrier de formation 2025–2026

Valable pour MLSD FI & FA (2025–2026).

Termes statistiques essentiels

Variance : Mesure de la dispersion des données autour de la moyenne. Plus la variance est grande, plus les données sont dispersées.

Valeurs propres (Eigenvalues) : Les scalaires associés aux vecteurs propres d'une matrice, décrivant dans quelle mesure ces vecteurs sont étirés ou compressés par la transformation linéaire.

Biais (Bias) : Différence entre la valeur attendue d'un estimateur et la vraie valeur d'un paramètre. Un modèle biaisé peut manquer de précision.

Écart-type (Standard Deviation) : Racine carrée de la variance. Il exprime la dispersion des données par rapport à la moyenne dans la même unité que les données.

Quartiles : Valeurs qui divisent un ensemble de données en quatre parties égales. Le premier quartile (Q1), la médiane (Q2), et le troisième quartile (Q3).

Loi de Bernoulli : Loi de probabilité qui décrit une expérience aléatoire ayant deux issues possibles (succès (p) ou échec (1-p)), avec une probabilité fixe de succès.

Loi normale (Gaussian Distribution) : Loi de probabilité continue symétrique en forme de cloche, définie par une moyenne μ et un écart-type σ, très utilisée pour modéliser des phénomènes naturels et de nombreuses approximations statistiques.

Loi de Poisson : Distribution de probabilité discrète qui modélise le nombre d'événements se produisant dans un intervalle de temps ou d'espace fixe, lorsque ces événements surviennent indépendamment et à un taux constant.

Espérance mathématique (Expected Value) : Moyenne pondérée des résultats d'une variable aléatoire. C'est la valeur centrale attendue d'une expérience aléatoire.

P-value : Probabilité, sous l’hypothèse nulle, d’observer une statistique de test au moins aussi extrême que celle mesurée. Utilisée pour évaluer la significativité statistique d’un résultat.

Intervalle de confiance (Confidence Interval) : Plage de valeurs qui, avec une certaine probabilité, contient la vraie valeur d'un paramètre statistique.

Régression linéaire : Technique statistique utilisée pour modéliser la relation entre une variable dépendante et une ou plusieurs variables indépendantes.

Surapprentissage (Overfitting) : Situation où un modèle est trop ajusté aux données d'entraînement, ce qui nuit à sa généralisation sur des données nouvelles.

Sous-apprentissage (Underfitting) : Modèle trop simple pour capturer les relations sous-jacentes dans les données, conduisant à une mauvaise performance.

Matrice de confusion : Tableau utilisé pour évaluer la performance d'un modèle de classification en comptant les vraies et fausses prédictions.

Test d'hypothèse : Méthode statistique pour tester une affirmation sur un paramètre de population en utilisant les données d'un échantillon.

Bootstrap : Technique de rééchantillonnage qui permet d'estimer les propriétés d'un estimateur en rééchantillonnant avec remplacement.

AIC/BIC : Critères utilisés pour comparer différents modèles statistiques en combinant qualité d’ajustement et pénalisation de la complexité du modèle.

Analyse en composantes principales (ACP) : Méthode de réduction de dimensionnalité qui transforme des variables corrélées en nouvelles variables non corrélées tout en conservant l'essentiel de la variance.

Matrice : Un tableau de nombres disposés en lignes et en colonnes, utilisé pour organiser des ensembles de données et des transformations linéaires.

Covariance : Mesure de la manière dont deux variables varient ensemble. Si la covariance est positive, les deux variables augmentent ensemble, si elle est négative, elles varient en sens inverse.

Matrice de covariance : Matrice carrée qui présente les covariances entre chaque paire de variables dans un ensemble de données.

Vecteur : Une liste ordonnée de nombres qui représente une quantité ayant une direction et une magnitude. Les vecteurs sont utilisés dans des espaces de haute dimension.

Autovalues (Valeurs propres) : Les scalaires associés aux vecteurs propres d'une matrice. Utilisées pour comprendre des caractéristiques fondamentales des transformations linéaires.

Autovecteurs (Vecteurs propres) : Les vecteurs associés aux valeurs propres qui ne changent pas de direction lors de la transformation par une matrice.

Régularisation : Technique utilisée pour ajouter une pénalité aux modèles statistiques afin d’éviter le surapprentissage.

Régression Ridge : Forme de régression linéaire qui inclut une régularisation L2 pour pénaliser les grands coefficients afin de réduire le surapprentissage.

Régression Lasso : Forme de régression linéaire qui inclut une régularisation L1 pour favoriser la parcimonie en forçant certains coefficients à zéro.

Gradient Descent : Algorithme d'optimisation utilisé pour minimiser la fonction de coût dans les modèles d’apprentissage machine.

Chaîne de Markov : Modèle stochastique décrivant une suite d’états où la probabilité de passer à l’état suivant dépend uniquement de l’état actuel, pas de l’historique complet.

Matrice de corrélation : Une matrice qui montre la corrélation entre chaque paire de variables. Utile pour repérer les relations linéaires entre les variables.

Loi des grands nombres : Théorème indiquant que, pour des variables aléatoires indépendantes et identiquement distribuées (i.i.d.) avec une variance finie, à mesure que le nombre d'échantillons augmente, la moyenne d’un échantillon converge vers la moyenne théorique de la population.

Maximum de vraisemblance (MLE) : Méthode d’estimation des paramètres d’un modèle statistique consistant à maximiser la fonction de vraisemblance. C’est l’une des approches les plus utilisées en statistique.

Algorithme K-means : Algorithme de clustering non supervisé qui partitionne les données en k groupes en minimisant la distance intra-cluster.

Réseaux bayésiens : Structures de données en forme de graphe qui représentent les relations probabilistes entre des variables.

K-Nearest Neighbors (K-NN) : Algorithme utilisé pour la classification basé sur la similarité des points voisins dans l'espace des données.

Distance euclidienne : Mesure de la distance directe entre deux points dans un espace multi-dimensionnel. Utilisée dans les algorithmes de clustering.

Normalisation et standardisation : Techniques de prétraitement des données qui ramènent les données dans un intervalle fixe ou une distribution normalisée.

Test de Chi-carré : Test statistique utilisé pour déterminer si une relation existe entre deux variables catégorielles.

Méthode des moindres carrés : Méthode utilisée pour ajuster un modèle de régression en minimisant la somme des carrés des différences entre les valeurs observées et prédites.

Variance expliquée : Proportion de la variance totale d'un ensemble de données qui est expliquée par un modèle statistique.

Effet de levier (Leverage) : Mesure de l'influence d'un point de données sur la régression.

Information Entropy (Entropie) : Mesure de l'incertitude ou de la quantité d'information contenue dans une variable aléatoire.

Mutual Information : Mesure de la dépendance entre deux variables, quantifiant combien connaître la valeur d'une variable réduit l'incertitude de l'autre.

Cross-validation : Technique utilisée pour évaluer la performance d’un modèle en le testant sur plusieurs sous-ensembles des données.

Random Forest : Algorithme basé sur la création de multiples arbres de décision pour améliorer la précision et réduire le risque de surapprentissage.

Réseaux de neurones convolutifs (CNN) : Type de réseau de neurones spécialisé dans le traitement des données structurées en grille, comme les images.

Réseaux de neurones récurrents (RNN) : Type de réseau de neurones adapté aux séquences de données, où les informations des étapes précédentes influencent les prédictions actuelles.

Courbe ROC (Receiver Operating Characteristic) : Courbe utilisée pour évaluer les performances d'un modèle de classification en traçant le taux de vrais positifs contre le taux de faux positifs.

AUC (Area Under the Curve) : Surface sous la courbe ROC, utilisée comme une mesure de performance globale d’un modèle de classification.

Batch Normalization : Technique utilisée dans les réseaux de neurones pour normaliser les activations d'une couche, accélérant l'entraînement et améliorant la stabilité.

Dropout : Méthode de régularisation pour les réseaux de neurones consistant à désactiver aléatoirement certains neurones pendant l'entraînement afin de réduire le surapprentissage.

Ensemble Learning : Technique combinant plusieurs modèles pour améliorer la performance globale, comme le bagging, boosting ou stacking.

XGBoost : Implémentation optimisée de gradient boosting très performante pour les tâches de classification et de régression.

LightGBM : Bibliothèque de gradient boosting optimisée pour les gros ensembles de données, développée par Microsoft.

Rapport de cotes (Odds Ratio) : Mesure du rapport des chances d’un événement entre deux groupes, couramment utilisée en épidémiologie et dans les études de cas-témoins.

Coefficient de corrélation de Pearson : Mesure linéaire de la relation entre deux variables quantitatives, variant entre -1 et +1.

Coefficient de corrélation de Spearman : Mesure non paramétrique de corrélation basée sur les rangs des données.

Intervalle de crédibilité : Intervalle estimé dans lequel un paramètre a une probabilité donnée de se trouver, utilisé en statistique bayésienne.

Bayes' Theorem : Formule permettant de calculer la probabilité conditionnelle d’un événement à partir d’informations préalables.

Feature Engineering : Processus de création, transformation et sélection des variables (features) pour améliorer la performance d’un modèle.

One-Hot Encoding : Technique de transformation des variables catégorielles en variables binaires utilisables par les algorithmes de machine learning.

Word Embeddings : Représentations vectorielles des mots, comme Word2Vec ou GloVe, capturant les relations sémantiques entre mots.

Test t de Student : Test statistique utilisé pour comparer la moyenne de deux groupes et déterminer si la différence est significative.

ANOVA (Analyse de la variance) : Test statistique permettant de comparer les moyennes de plusieurs groupes.

Régression logistique : Modèle statistique utilisé pour prédire une variable binaire à partir de variables explicatives.

Elastic Net : Technique de régression combinant les régularisations L1 (Lasso) et L2 (Ridge).

Valeur aberrante (Outlier) : Observation qui s'écarte fortement des autres valeurs d'un jeu de données.

SMOTE (Synthetic Minority Over-sampling Technique) : Méthode de rééchantillonnage synthétique pour équilibrer des classes déséquilibrées.

Kurtosis (Aplatissement) : Mesure décrivant la forme de la distribution, en particulier la concentration des valeurs dans les queues.

Skewness (Asymétrie) : Mesure indiquant si une distribution est symétrique ou penche vers la gauche/droite.

Markov Chain : Modèle stochastique décrivant une séquence d’événements où la probabilité de chaque événement ne dépend que de l’état précédent.

Gradient Boosting : Méthode d’ensemble qui construit des modèles de manière séquentielle, chaque nouveau modèle corrigeant les erreurs des précédents.

CatBoost : Bibliothèque de gradient boosting optimisée pour les variables catégorielles, développée par Yandex.

Bagging : Technique d’ensemble qui entraîne plusieurs modèles indépendamment sur des échantillons bootstrapés, puis agrège leurs prédictions.

AdaBoost : Méthode de boosting adaptatif qui pondère les erreurs pour se concentrer sur les exemples difficiles à classer.

Hyperparameter Tuning : Processus d’optimisation des paramètres d’un modèle pour améliorer ses performances (grid search, random search, bayesian optimization).

Early Stopping : Technique d'arrêt anticipé de l'entraînement d’un modèle lorsque la performance sur un jeu de validation cesse de s'améliorer.

Processus de Poisson : Modèle stochastique de comptage décrivant le nombre d’événements se produisant dans un intervalle de temps fixe, avec des incréments indépendants et un taux constant.

Colinéarité : Situation où deux ou plusieurs variables explicatives sont fortement corrélées, rendant l’estimation des coefficients instable.

Multicolinéarité : Forme extrême de colinéarité impliquant plusieurs variables, pouvant affecter la robustesse des modèles linéaires.

Théorème central limite (Central Limit Theorem) : Théorème stipulant que, pour un grand nombre de variables aléatoires indépendantes et identiquement distribuées (i.i.d.) ayant une variance finie, la distribution de leur somme ou de leur moyenne tend vers une loi normale, quelle que soit la distribution d’origine.

Analyse discriminante linéaire (LDA) : Méthode de classification qui projette les données sur un espace de dimension réduite maximisant la séparation entre classes.

Régression polynomiale : Extension de la régression linéaire qui modélise des relations non linéaires en introduisant des puissances des variables explicatives.

Régression PLS (Partial Least Squares) : Méthode adaptée aux données fortement corrélées et aux situations avec plus de variables que d’observations.

Norme vectorielle : Mesure de la taille ou de la longueur d’un vecteur, comme les normes L1, L2 et L∞.

Produit scalaire : Opération entre deux vecteurs donnant un nombre, représentant la projection d’un vecteur sur un autre.

Produit matriciel : Opération qui combine deux matrices pour produire une troisième, utilisée dans de nombreuses transformations linéaires.

Décomposition en valeurs singulières (SVD) : Factorisation d’une matrice en trois matrices, utilisée pour la réduction de dimension et la compression.

Apprentissage par transfert (Transfer Learning) : Réutilisation d’un modèle pré-entraîné sur un problème similaire pour accélérer l’apprentissage sur un nouveau problème.

Apprentissage semi-supervisé : Technique exploitant à la fois des données étiquetées et non étiquetées pour améliorer les performances d’un modèle.

Apprentissage auto-supervisé : Technique où un modèle génère ses propres labels à partir des données brutes pour pré-entraîner ses représentations.

GAN (Generative Adversarial Network) : Architecture de deep learning composée d’un générateur et d’un discriminateur, utilisée pour créer des données synthétiques réalistes.

Autoencoder : Réseau de neurones entraîné à reconstruire ses entrées après les avoir compressées, utilisé pour la réduction de dimension et la détection d’anomalies.

Fonction de densité de probabilité (PDF) : Fonction qui décrit la répartition d’une variable aléatoire continue. La probabilité que la variable prenne une valeur dans un intervalle donné correspond à l’intégrale de cette densité sur cet intervalle.

Fonction de masse de probabilité (PMF) : Fonction qui associe à chaque valeur possible d’une variable aléatoire discrète la probabilité que cette valeur se réalise.

Loi uniforme : Loi de probabilité continue où toutes les valeurs d’un intervalle ont la même probabilité.

Loi log-normale : Loi de probabilité continue pour une variable dont le logarithme suit une loi normale ; utilisée pour modéliser des phénomènes multiplicatifs.

Loi du chi-deux (χ²) : Loi de probabilité continue, définie uniquement pour des valeurs positives, utilisée dans les tests du chi-deux et l’estimation de variance, paramétrée par ses degrés de liberté.

Loi de Student (t) : Loi de probabilité continue utilisée pour estimer ou tester une moyenne lorsque la taille d’échantillon est petite et que la variance de la population est inconnue.

Loi de Fisher-Snedecor (F) : Loi de probabilité continue utilisée pour comparer des variances dans les tests d'analyse de variance (ANOVA).

Loi bêta : Loi de probabilité continue définie sur [0, 1], paramétrée par deux coefficients positifs, utilisée pour modéliser des proportions.

Loi gamma : Loi de probabilité continue utilisée pour modéliser des temps d’attente ou des durées, paramétrée par un coefficient de forme et un coefficient de taux (ou d’échelle).

Loi binomiale : Loi de probabilité discrète qui donne la probabilité d'obtenir un nombre donné de succès dans un nombre fixe d'essais indépendants.

Loi géométrique : Loi de probabilité discrète qui donne la probabilité que le premier succès survienne au kᵉ essai, pour des essais indépendants avec probabilité de succès constante.

Loi hypergéométrique : Loi de probabilité discrète qui modélise le nombre de succès dans un échantillon tiré sans remise d'une population finie.

Loi binomiale négative : Loi de probabilité discrète qui modélise le nombre d’échecs avant d’obtenir un nombre fixé de succès, pour des essais indépendants avec probabilité de succès constante.

Loi exponentielle : Loi de probabilité continue qui modélise le temps entre deux événements dans un processus à taux constant.

Médiane : Valeur qui sépare un ensemble de données ordonnées en deux parties de même taille. Robuste aux valeurs extrêmes, elle est souvent utilisée comme mesure centrale alternative à la moyenne.

Mode : Valeur ou catégorie la plus fréquente dans un ensemble de données. Utile pour les données qualitatives et quantitatives discrètes.

IQR (Intervalle inter-quartile) : Différence entre le troisième quartile (Q3) et le premier quartile (Q1). Mesure robuste de dispersion, insensible aux valeurs aberrantes.

MAD (Median Absolute Deviation) : Médiane des valeurs absolues des écarts à la médiane. Indicateur robuste de la dispersion des données.

Z-score : Valeur standardisée indiquant combien d’écarts-types une observation se situe par rapport à la moyenne, permettant de comparer des valeurs issues de distributions différentes.

Taille d’effet (Cohen’s d) : Mesure normalisée de la différence entre deux moyennes, exprimée en nombre d’écarts-types. Permet d’évaluer l’importance pratique d’un effet au-delà de la significativité statistique.

Taille d’effet (r) : Mesure basée sur un coefficient de corrélation ou extraite de statistiques de test, exprimant la force de l’association entre deux variables.

Puissance statistique : Probabilité qu’un test détecte un effet réel (1 − β). Dépend de la taille de l’effet, de l’échantillon et du seuil α choisi.

Erreur de type I (α) : Rejeter l’hypothèse nulle alors qu’elle est vraie. Correspond au risque de faux positif, fixé par le seuil de significativité.

Erreur de type II (β) : Ne pas rejeter l’hypothèse nulle alors qu’elle est fausse. Correspond au risque de faux négatif.

Tests multiples : Ensemble de procédures pour ajuster le seuil de significativité lorsque plusieurs tests sont effectués, afin de limiter l’inflation des faux positifs (ex. Bonferroni, Benjamini–Hochberg).

Hétéroscédasticité : Situation où la variance des résidus n’est pas constante à travers les valeurs des prédicteurs. Pose problème pour les modèles linéaires classiques.

Boîte à moustaches : Représentation graphique résumant la médiane, l’IQR et les valeurs extrêmes. Utilisée pour visualiser la dispersion et détecter les valeurs aberrantes.

QQ-plot : Graphique comparant les quantiles d’un échantillon avec ceux d’une distribution théorique, souvent utilisé pour vérifier l’hypothèse de normalité.

Probabilité conditionnelle : Probabilité qu’un événement A se produise sachant qu’un événement B est réalisé. Notée P(A|B) et définie par P(A∩B)/P(B).

Indépendance : Deux événements A et B sont indépendants si la réalisation de l’un n’influence pas la probabilité de l’autre, soit P(A∩B)=P(A)P(B).

Loi multinomiale : Extension de la loi binomiale à k issues possibles par essai. Modélise la probabilité d’obtenir des effectifs spécifiques sur n essais indépendants.

CDF (Fonction de répartition) : Fonction donnant, pour toute valeur x, la probabilité que la variable aléatoire soit inférieure ou égale à x. Notée F(x)=P(X≤x).

Quantiles / Percentiles : Valeurs seuils qui divisent une distribution en intervalles contenant des proportions spécifiques des observations.

Fonction génératrice des moments (MGF) : Fonction M(t)=E[e^{tX}] qui, si elle existe, permet d’obtenir tous les moments d’une variable aléatoire en dérivant M(t) en t=0.

Fonction caractéristique : Fonction φ(t)=E[e^{itX}] toujours définie, utilisée notamment pour étudier les sommes de variables aléatoires et la convergence en loi.

Inégalité de Markov : Pour une variable aléatoire positive X, P(X≥a) ≤ E[X]/a. Fournit une borne de probabilité sans hypothèse forte sur la distribution.

Inégalité de Tchebychev : Pour toute variable X de moyenne μ et variance σ², P(|X−μ|≥kσ) ≤ 1/k². Encadre la dispersion autour de la moyenne.

Inégalité de Jensen : Pour une fonction convexe f, f(E[X]) ≤ E[f(X)]. Utilisée en optimisation et théorie des probabilités.

Variables continues : Variables pouvant prendre une infinité de valeurs réelles dans un intervalle, modélisées par une PDF.

Variables discrètes : Variables ne pouvant prendre qu’un ensemble dénombrable de valeurs, modélisées par une PMF.

Hypothèses OLS : Ensemble de conditions nécessaires pour que les estimateurs de la régression linéaire soient optimaux : relation linéaire entre variables, indépendance des résidus, normalité des résidus, variance constante (homoscédasticité) et absence de multicolinéarité sévère.

R² : Coefficient de détermination mesurant la proportion de variance de la variable dépendante expliquée par le modèle. Une valeur proche de 1 indique un ajustement élevé.

R² ajusté : Version du R² qui pénalise les modèles avec de nombreuses variables non pertinentes, permettant de comparer des modèles avec un nombre de prédicteurs différent.

Diagnostics des résidus : Analyse graphique ou statistique des résidus pour vérifier les hypothèses de la régression (normalité, homoscédasticité, indépendance) et détecter d’éventuelles anomalies.

Durbin–Watson : Statistique utilisée pour détecter l’autocorrélation des résidus dans les modèles de régression appliqués à des données ordonnées dans le temps.

VIF (Variance Inflation Factor) : Indicateur mesurant le degré de multicolinéarité d’une variable explicative avec les autres. Un VIF élevé indique une corrélation forte avec d’autres variables du modèle.

GLM (Generalized Linear Model) : Famille de modèles statistiques généralisant la régression linéaire en permettant une distribution de réponse autre que normale et en utilisant une fonction de lien adaptée (logit, log, identité, etc.).

Fonctions de perte : Fonctions mesurant l’écart entre les valeurs prédites et observées, comme MSE (erreur quadratique moyenne), MAE (erreur absolue moyenne) ou Log-loss (perte logarithmique pour les probabilités).

Splines : Fonctions polynomiales par morceaux utilisées pour modéliser des relations non linéaires tout en assurant la continuité et la douceur aux points de jonction.

Termes d’interaction : Variables créées en multipliant deux prédicteurs afin de capturer l’effet combiné de ces variables sur la variable cible.

Split train/val/test : Division d’un jeu de données en trois ensembles : entraînement (train) pour ajuster le modèle, validation (val) pour optimiser les hyperparamètres, et test pour évaluer la performance finale sur des données inédites.

Validation croisée k-fold : Technique d’évaluation consistant à diviser les données en k sous-ensembles, à entraîner le modèle sur k-1 d’entre eux et à le tester sur le sous-ensemble restant, en répétant l’opération k fois pour obtenir une performance moyenne.

Précision (accuracy) : Proportion de prédictions correctes sur l’ensemble des prédictions effectuées par un modèle. Pertinente lorsque les classes sont équilibrées.

Rappel (recall) : Proportion de vrais positifs détectés parmi tous les positifs réels. Indique la capacité du modèle à identifier les exemples pertinents.

Spécificité : Proportion de vrais négatifs correctement identifiés parmi tous les négatifs réels. Utile pour évaluer la capacité à éviter les faux positifs.

F1 : Moyenne harmonique de la précision et du rappel. Favorise un équilibre entre les deux mesures, notamment en cas de classes déséquilibrées.

Matrice de coûts : Tableau attribuant un coût spécifique à chaque type d’erreur ou de bonne classification, permettant d’adapter la décision du modèle aux enjeux métier.

Courbe PR & AUPRC : Courbe représentant la précision en fonction du rappel pour différents seuils, et AUPRC étant l’aire sous cette courbe. Utile pour les jeux de données très déséquilibrés.

Calibration des probabilités : Processus visant à ajuster les probabilités prédites par un modèle afin qu’elles reflètent correctement les fréquences observées dans les données réelles.

Seuil de décision : Valeur limite appliquée aux probabilités prédites pour déterminer la classe attribuée par le modèle. Peut être ajusté pour équilibrer précision et rappel.

SVM (Support Vector Machine) : Algorithme de classification qui cherche à maximiser la marge entre les classes, avec possibilité d’utiliser des noyaux pour traiter des séparations non linéaires.

Naïve Bayes : Classifieur probabiliste basé sur le théorème de Bayes, supposant l’indépendance conditionnelle entre les variables explicatives.

Arbre de décision : Modèle prédictif structuré en nœuds de décision et feuilles de prédiction, permettant une interprétation simple des règles d’attribution des classes.

Clustering hiérarchique : Méthode de regroupement des données consistant à fusionner ou diviser les clusters de manière itérative pour former une hiérarchie représentée par un dendrogramme.

DBSCAN : Algorithme de clustering basé sur la densité, capable de détecter des groupes de formes quelconques et de gérer les points bruités.

Indice de silhouette : Mesure de la qualité d’un clustering, comparant la cohésion interne d’un cluster à sa séparation avec les autres clusters.

t-SNE : Technique de réduction de dimensionnalité non linéaire, optimisée pour la visualisation en 2D ou 3D des structures locales des données.

UMAP : Méthode de réduction de dimensionnalité rapide, conservant à la fois la structure locale et globale des données.

SHAP : Méthode d’explicabilité attribuant à chaque variable une contribution à la prédiction, basée sur les valeurs de Shapley issues de la théorie des jeux.

LIME : Technique d’explication locale approximant un modèle complexe par un modèle linéaire interprétable dans la zone d’un exemple particulier.

Pipelines : Chaînes ordonnées d’étapes de prétraitement et de modélisation permettant d’automatiser et de sécuriser l’entraînement d’un modèle.

Fuite de données (data leakage) : Introduction involontaire d’informations provenant des données de test dans l’entraînement, faussant les performances estimées du modèle.

Rang : Nombre maximum de colonnes ou de lignes linéairement indépendantes dans une matrice. Indique la dimension de l’espace engendré par ses colonnes ou ses lignes.

Déterminant : Scalaire calculé à partir d’une matrice carrée, indiquant le facteur d’échelle d’une transformation linéaire et permettant de savoir si la matrice est inversible (déterminant nul ⟺ matrice non inversible).

Trace : Somme des éléments diagonaux d’une matrice carrée, équivalente à la somme de ses valeurs propres. Utilisée en statistiques et en optimisation.

Matrice définie positive : Matrice symétrique pour laquelle xᵀAx > 0 pour tout vecteur non nul x. Garantit que la forme quadratique associée est strictement positive.

Semi-définie positive : Matrice symétrique pour laquelle xᵀAx ≥ 0 pour tout vecteur x. Les matrices de covariance sont typiquement semi-définies positives.

Orthogonalité : Relation entre deux vecteurs dont le produit scalaire est nul. Implique que les vecteurs sont perpendiculaires dans l’espace vectoriel.

Base orthonormée : Ensemble de vecteurs unitaires et mutuellement orthogonaux formant une base d’un espace vectoriel. Simplifie les calculs de projection et de transformation.

Projection : Transformation d’un vecteur sur un sous-espace, conservant la composante parallèle et éliminant la composante orthogonale.

Décomposition LU : Factorisation d’une matrice en produit d’une matrice triangulaire inférieure (L) et d’une matrice triangulaire supérieure (U), utilisée pour résoudre efficacement des systèmes d’équations linéaires.

Cholesky : Décomposition d’une matrice symétrique définie positive en produit LLᵀ, où L est triangulaire inférieure. Méthode rapide et stable pour l’inversion et la résolution de systèmes.

Gradient : Vecteur des dérivées partielles d’une fonction multivariable, pointant dans la direction de la plus forte augmentation de la fonction.

Jacobien : Matrice contenant les dérivées partielles premières d’un vecteur-fonction par rapport à ses variables. Décrit les variations locales d’une transformation multivariable.

Hessien : Matrice des dérivées secondes d’une fonction scalaire multivariable, décrivant la courbure locale. Utilisée pour analyser la convexité et optimiser les fonctions.

Stationnarité : Propriété d’une série temporelle dont la distribution statistique (moyenne, variance, autocorrélation) reste constante dans le temps. Condition souvent nécessaire pour certains modèles.

Saisonnalité : Présence de motifs qui se répètent à intervalles réguliers (jour, semaine, année). Courante dans les données économiques ou météorologiques.

Tendance : Composante à long terme de la série, représentant une hausse ou une baisse globale sur la période observée.

ACF (Autocorrelation Function) : Fonction mesurant la corrélation entre la série et ses propres valeurs décalées dans le temps. Utilisée pour détecter les dépendances temporelles.

PACF (Partial Autocorrelation Function) : Mesure de la corrélation entre la série et ses retards, en éliminant l’effet des retards intermédiaires. Sert à identifier l’ordre d’un modèle AR.

AR(p) : Modèle autorégressif où la valeur actuelle dépend d’une combinaison linéaire de ses p valeurs passées et d’un terme d’erreur aléatoire.

MA(q) : Modèle à moyenne mobile où la valeur actuelle dépend d’une combinaison linéaire des q dernières erreurs aléatoires.

ARMA(p,q) : Modèle combinant une composante autorégressive (AR) et une composante à moyenne mobile (MA), adapté aux séries stationnaires.

ARIMA(p,d,q) : Extension d’ARMA intégrant une différenciation d’ordre d pour rendre la série stationnaire. Très utilisé en prévision.

Lissage exponentiel : Méthode de prévision donnant plus de poids aux observations récentes via un facteur d’atténuation exponentiel.

ETS : Famille de modèles combinant Erreur, Tendance et Saisonnalité, de manière additive ou multiplicative, pour modéliser des séries temporelles.

Randomisation : Attribution aléatoire des sujets ou unités aux groupes de traitement et de contrôle, afin de réduire les biais et équilibrer les facteurs confondants.

Groupe contrôle : Ensemble de sujets ne recevant pas l’intervention testée, servant de référence pour mesurer l’effet du traitement.

Effet traitement vs effet levier : Différencier l’impact réel de l’intervention de simples effets liés à l’exposition ou à la sélection des participants.

P-hacking : Manipulation des analyses statistiques ou sélection opportuniste des données pour obtenir artificiellement des résultats significatifs.

Test séquentiel : Méthode permettant d’analyser les résultats à intervalles réguliers pendant l’expérimentation, avec ajustement du seuil statistique pour contrôler le risque d’erreur de type I.

Taille d’échantillon : Nombre minimal d’observations nécessaire pour garantir une puissance statistique suffisante et détecter un effet d’ampleur donnée.

Théorème central limite (Central Limit Theorem) : Théorème stipulant que, pour un grand nombre de variables aléatoires indépendantes et identiquement distribuées (i.i.d.) ayant une variance finie, la distribution de leur somme ou de leur moyenne tend vers une loi normale, quelle que soit la distribution d’origine.

Simulations interactives

Choisis une loi, règle les paramètres et observe sa PDF (continue) ou PMF (discrète).

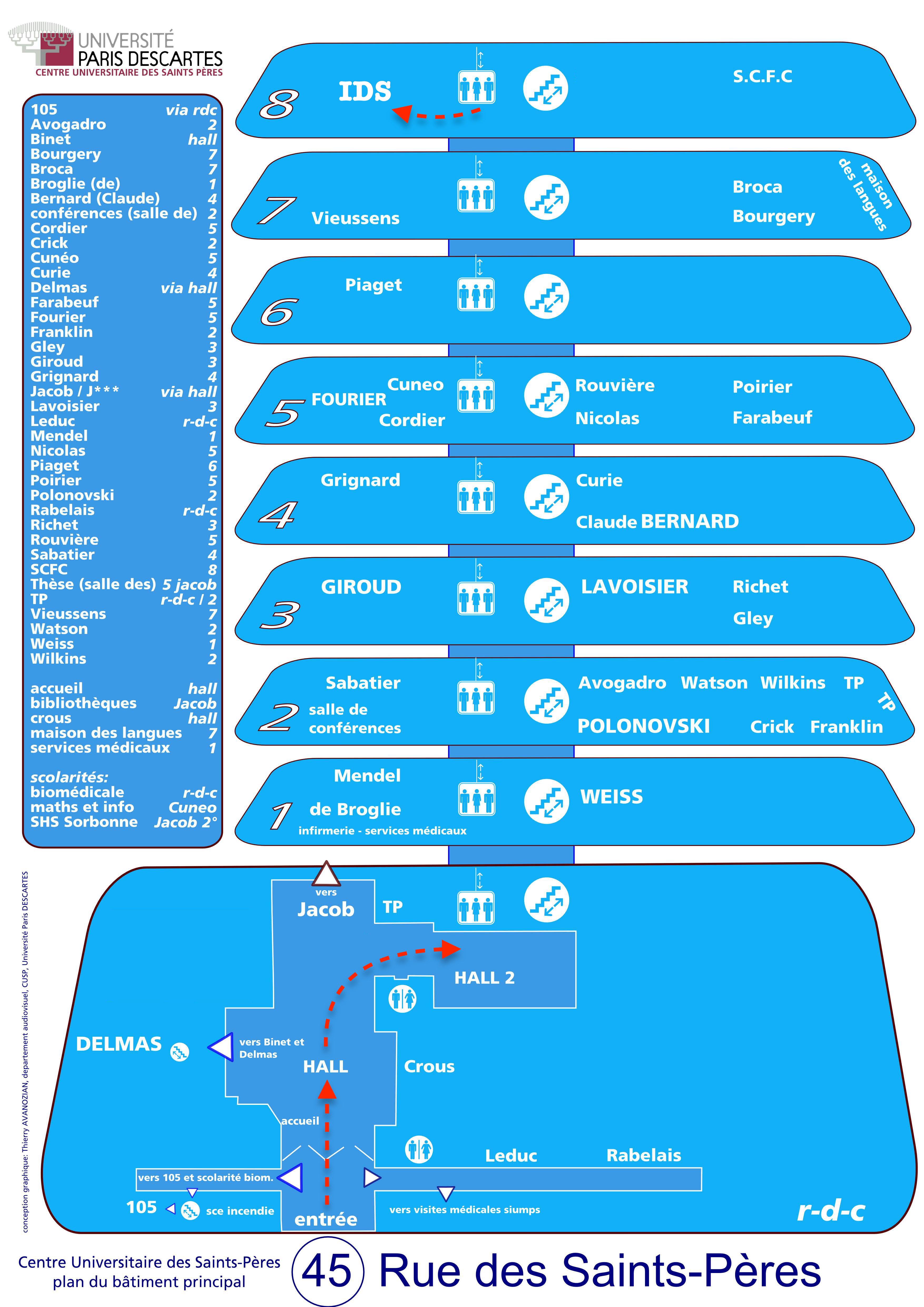

Plan du bâtiment principal